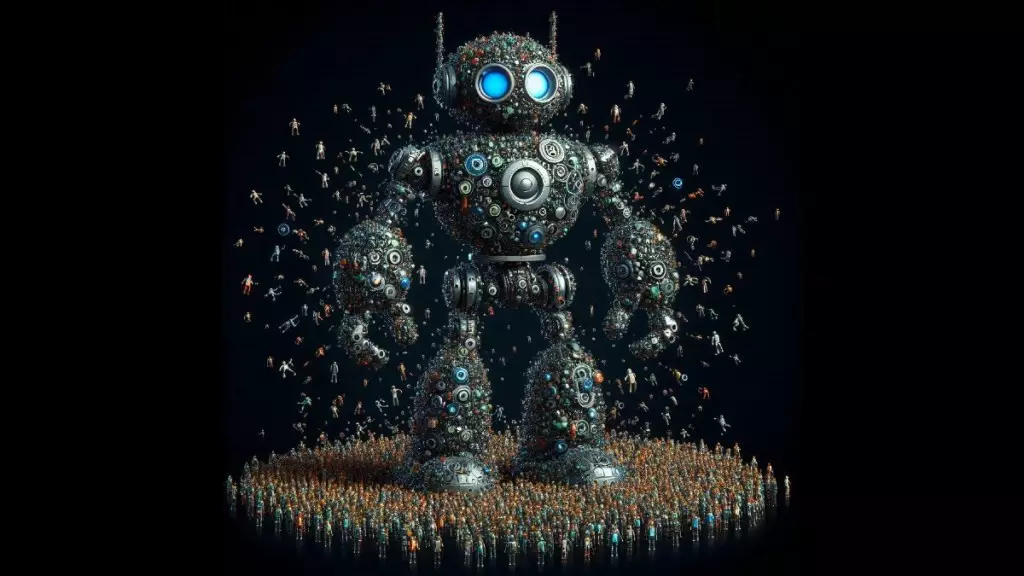

Mixture-of-Experts (MoE) se ha convertido en una técnica popular para escalar modelos de lenguaje grandes (LLMs) sin aumentar los costos computacionales de forma significativa. En lugar de utilizar toda la capacidad del modelo para cada entrada, las arquitecturas MoE enrutan los datos hacia módulos especializados y pequeños llamados «expertos». MoE permite a los LLMs aumentar sus parámetros manteniendo bajos los costos de inferencia. MoE se utiliza en varios LLMs populares, incluyendo Mixtral, DBRX, Grok y supuestamente GPT-4. Sin embargo, las técnicas actuales de MoE tienen limitaciones que los restringen a un número relativamente pequeño de expertos.

En un nuevo artículo, Google DeepMind introduce Parameter Efficient Expert Retrieval (PEER), una arquitectura innovadora que puede escalar los modelos MoE a millones de expertos, mejorando aún más el equilibrio entre rendimiento y costos computacionales de los grandes modelos de lenguaje. Los últimos años han demostrado que escalar modelos de lenguaje aumentando su cantidad de parámetros conlleva a un rendimiento mejorado y nuevas capacidades. Sin embargo, hay un límite en cuánto se puede escalar un modelo antes de encontrarse con cuellos de botella computacionales y de memoria.

Cada bloque transformador utilizado en los LLMs tiene capas de atención y capas de feedforward (FFW). La capa de atención calcula las relaciones entre la secuencia de tokens alimentados al bloque transformador. La red feedforward es responsable de almacenar el conocimiento del modelo. Las capas FFW representan dos tercios de los parámetros del modelo y son uno de los cuellos de botella en la escalabilidad de los transformadores.

MoE intenta abordar este desafío reemplazando al FFW con módulos de expertos activados de forma dispersa en lugar de una única capa densa de FFW. Cada uno de los expertos contiene una fracción de los parámetros de la capa densa completa y se especializa en ciertas áreas. El MoE tiene un enrutador que asigna cada entrada a varios expertos que probablemente ofrecerán la respuesta más precisa. Aumentando el número de expertos, MoE puede aumentar la capacidad del LLM sin incrementar el costo computacional de su funcionamiento.

Según estudios recientes, el número óptimo de expertos para un modelo MoE está relacionado con varios factores, incluyendo el número de tokens de entrenamiento y el presupuesto de cómputo. Cuando se equilibran estas variables, los MoEs han superado consistentemente a los modelos densos para la misma cantidad de recursos computacionales. Además, aumentar la «granularidad» de un modelo MoE, que se refiere al número de expertos, puede conducir a mejoras en el rendimiento, especialmente cuando se acompaña de un aumento en el tamaño del modelo y los datos de entrenamiento. La MoE de alta granularidad también puede permitir que los modelos aprendan nuevos conocimientos de manera más eficiente.

Los enfoques actuales de MoE son limitados y no escalables. El enfoque PEER de DeepMind aborda los desafíos de la escalabilidad de MoE a millones de expertos. PEER reemplaza el enrutador fijo con un índice aprendido para enrutar eficientemente los datos de entrada a una amplia gama de expertos. Para cada entrada dada, PEER primero crea una lista corta de posibles candidatos antes de elegir y activar a los mejores expertos. Este mecanismo permite al MoE manejar un gran número de expertos sin ralentizarse.

Conclusión: PEER como alternativa competitiva

Los investigadores evaluaron el rendimiento de PEER en diferentes pruebas, comparándolo con modelos transformadores con capas densas de feedforward y otras arquitecturas de MoE. Sus experimentos muestran que los modelos PEER logran un mejor equilibrio entre rendimiento y recursos computacionales, alcanzando puntuaciones más bajas de perplejidad con el mismo presupuesto computacional que sus contrapartes. Los hallazgos desafían la creencia de que los modelos MoE alcanzan la máxima eficiencia con un número limitado de expertos. PEER muestra que al aplicar los mecanismos de recuperación y enrutamiento adecuados, es posible escalar MoE a millones de expertos, reduciendo aún más el costo y la complejidad de entrenar y servir modelos de lenguaje muy grandes.

Deja una respuesta