En el ámbito de los algoritmos de optimización, el tamaño de paso, también conocido como tasa de aprendizaje, desempeña un papel crucial en la determinación de la eficiencia del algoritmo de descenso de gradiente estocástico (SGD). Es responsable de controlar la cantidad por la cual se actualizan los parámetros del modelo durante cada iteración.

El problema con los métodos tradicionales de tamaño de paso

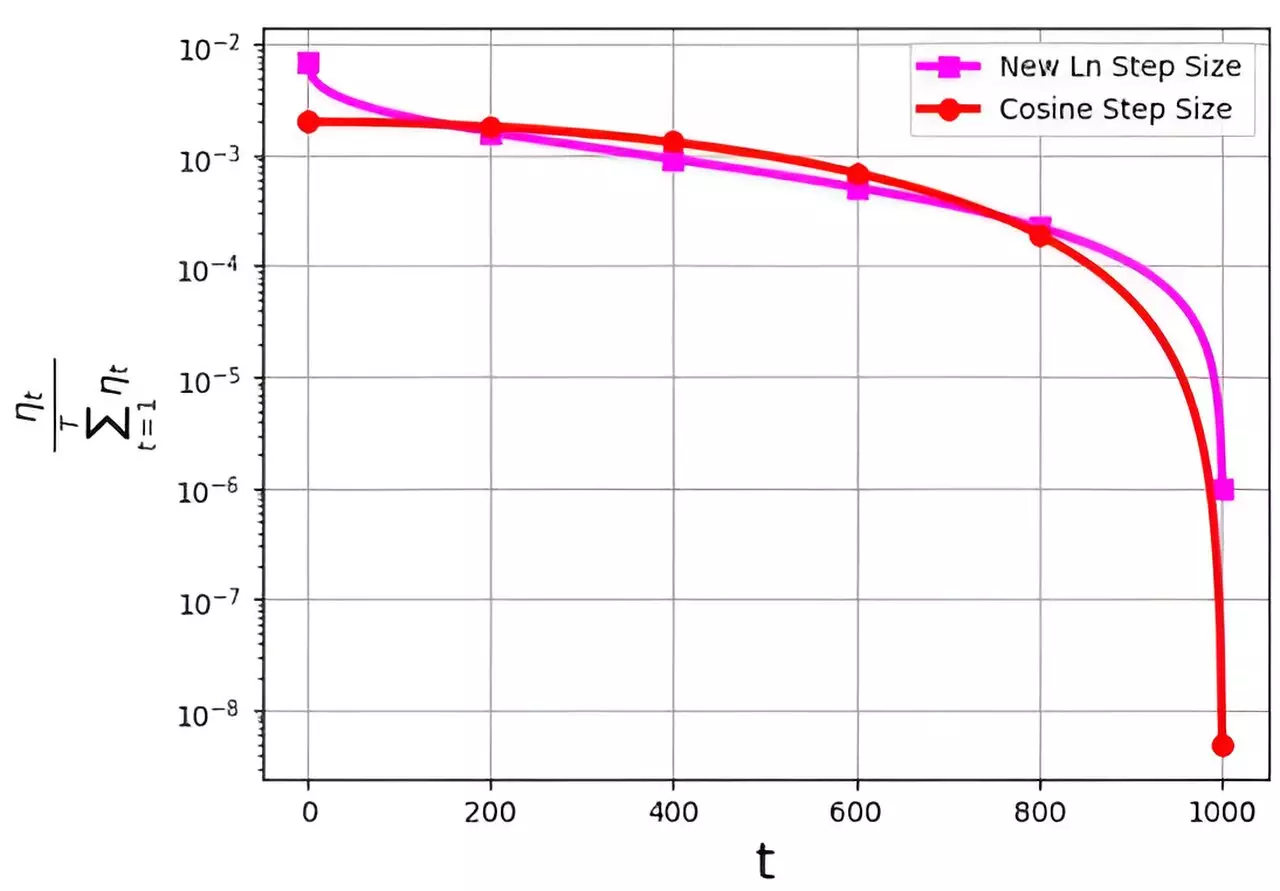

Uno de los principales desafíos asociados con diferentes estrategias de tamaño de paso es la distribución de probabilidad a lo largo de las iteraciones. Esta distribución, denotada como ηt/ΣTt=1ηt, está diseñada para evitar asignar valores extremadamente pequeños a las iteraciones finales. Sin embargo, ciertos métodos populares de tamaño de paso, como el paso de coseno, tienden a enfrentar problemas al asignar valores de probabilidad muy bajos a las iteraciones finales.

Introducción del tamaño de paso logarítmico

Para abordar las limitaciones de las estrategias tradicionales de tamaño de paso, un equipo de investigación liderado por M. Soheil Shamaee ha introducido un nuevo tamaño de paso logarítmico para el algoritmo SGD. Su investigación, publicada en Frontiers of Computer Science, muestra la efectividad de este nuevo enfoque, especialmente durante las iteraciones finales del proceso de optimización.

Resultados del nuevo enfoque

El nuevo tamaño de paso logarítmico propuesto demuestra una mayor probabilidad de selección durante las críticas iteraciones finales en comparación con el tradicional tamaño de paso de coseno. Esta mayor probabilidad de ser elegido como la solución seleccionada contribuye a una mejora en el rendimiento y eficiencia en la optimización del algoritmo SGD.

Experimentos realizados en conjuntos de datos como FashionMinst, CIFAR10 y CIFAR100 resaltan el rendimiento superior del método de tamaño de paso logarítmico. Especialmente notable es el aumento del 0.9% en la precisión de las pruebas logrado al aplicar el nuevo método de tamaño de paso en conjunto con un modelo de red neuronal convolucional (CNN) en el conjunto de datos CIFAR100.

En general, la introducción del tamaño de paso logarítmico presenta un avance prometedor en la optimización de la eficiencia del algoritmo SGD. Al abordar los desafíos asociados con la distribución de probabilidad de los tamaños de paso, este enfoque innovador ofrece mejoras tangibles en el rendimiento y la precisión, especialmente en las críticas iteraciones finales del proceso de optimización.

Deja una respuesta