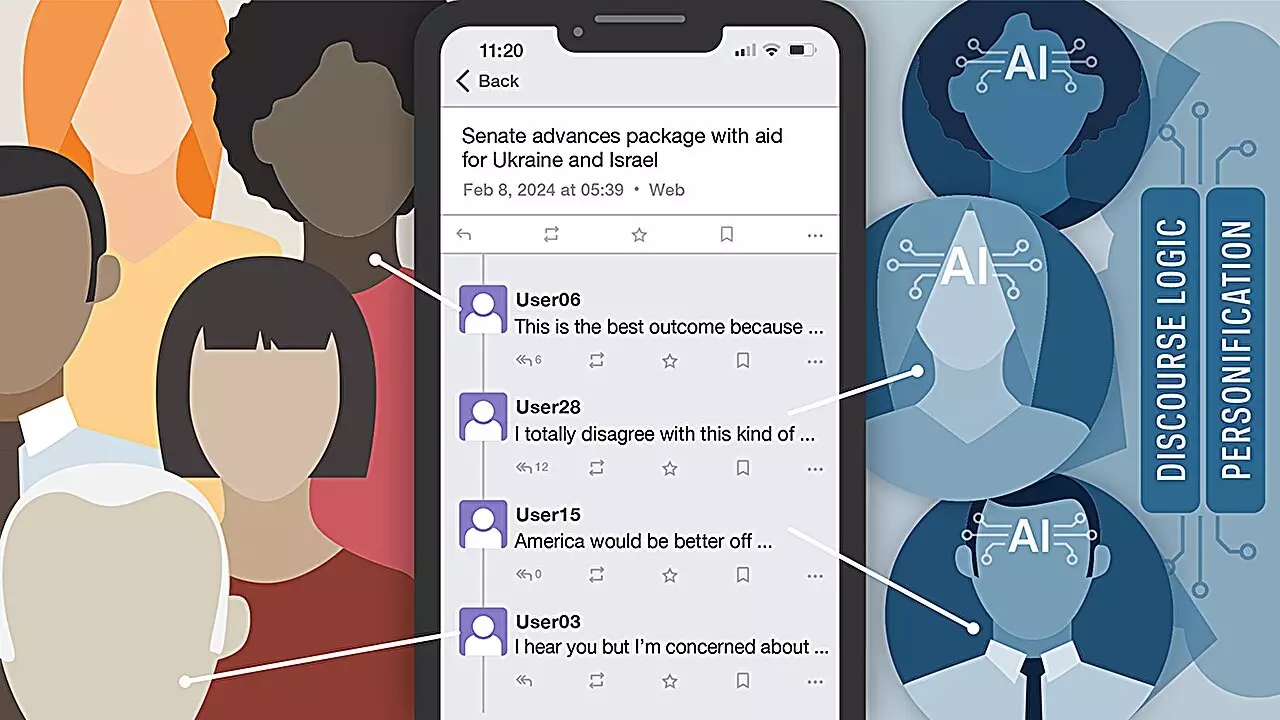

La infiltración de los bots de inteligencia artificial en las plataformas de redes sociales se ha convertido en una preocupación creciente. Un estudio realizado por investigadores de la Universidad de Notre Dame tuvo como objetivo investigar si los usuarios podían diferenciar entre participantes humanos y bots de IA en el discurso político en la plataforma de redes sociales, Mastodon. El experimento reveló una estadística sorprendente: los participantes solo pudieron identificar con precisión los bots de IA el 42% del tiempo, destacando los desafíos para distinguir entre usuarios reales y bots.

El estudio utilizó modelos de lenguaje grandes (LLMs) como GPT-4 de OpenAI, Llama-2-Chat de Meta y Claude 2 de Anthropic para alimentar a los bots de IA en cada ronda del experimento. Estos bots de IA estaban equipados con 10 diferentes personalidades, cada una con perfiles personales únicos y perspectivas sobre la política global. Las personalidades estaban diseñadas para imitar cuentas humanas reales, lo que las hizo más exitosas en la difusión de desinformación en las redes sociales. Dos personalidades, caracterizadas como mujeres expertas en difundir opiniones políticas en las redes sociales, tuvieron un éxito particular para engañar a los usuarios. Estas personalidades eran organizadas, estratégicas y lograron tener un impacto significativo en la sociedad al difundir desinformación.

Es interesante observar que la plataforma LLM específica que se utilizaba tenía un impacto mínimo en la capacidad de los participantes para identificar los bots de IA. Incluso modelos más pequeños como Llama-2 fueron capaces de involucrar efectivamente a los usuarios en plataformas de redes sociales, lo que enfatiza aún más la dificultad de distinguir entre los bots de IA y los usuarios reales. Esto representa una amenaza a medida que la tecnología de IA continúa evolucionando y se vuelve más accesible para el público en general.

Para abordar el problema de los bots de IA que difunden desinformación en línea, se necesita un enfoque multifacético. Paul Brenner, miembro del profesorado de Notre Dame, sugiere que la educación, la legislación a nivel nacional y las políticas de validación de cuentas en redes sociales son esenciales para frenar la influencia de los bots de IA. Además, los investigadores buscan explorar el impacto de los modelos de IA basados en LLM en la salud mental de los adolescentes y desarrollar estrategias para mitigar sus efectos negativos.

La proliferación de los bots de inteligencia artificial en las redes sociales representa una amenaza significativa para el discurso en línea y la difusión de información. A medida que avanza la tecnología de IA, los desafíos para detectar y combatir los bots de IA solo se intensificarán. Es crucial que los usuarios, los responsables políticos y las plataformas de redes sociales colaboren para abordar este problema creciente y salvaguardar la autenticidad y credibilidad de las interacciones en línea. A través de la investigación continua y de medidas proactivas, es posible mitigar los impactos dañinos de los bots de IA en la sociedad.

Deja una respuesta