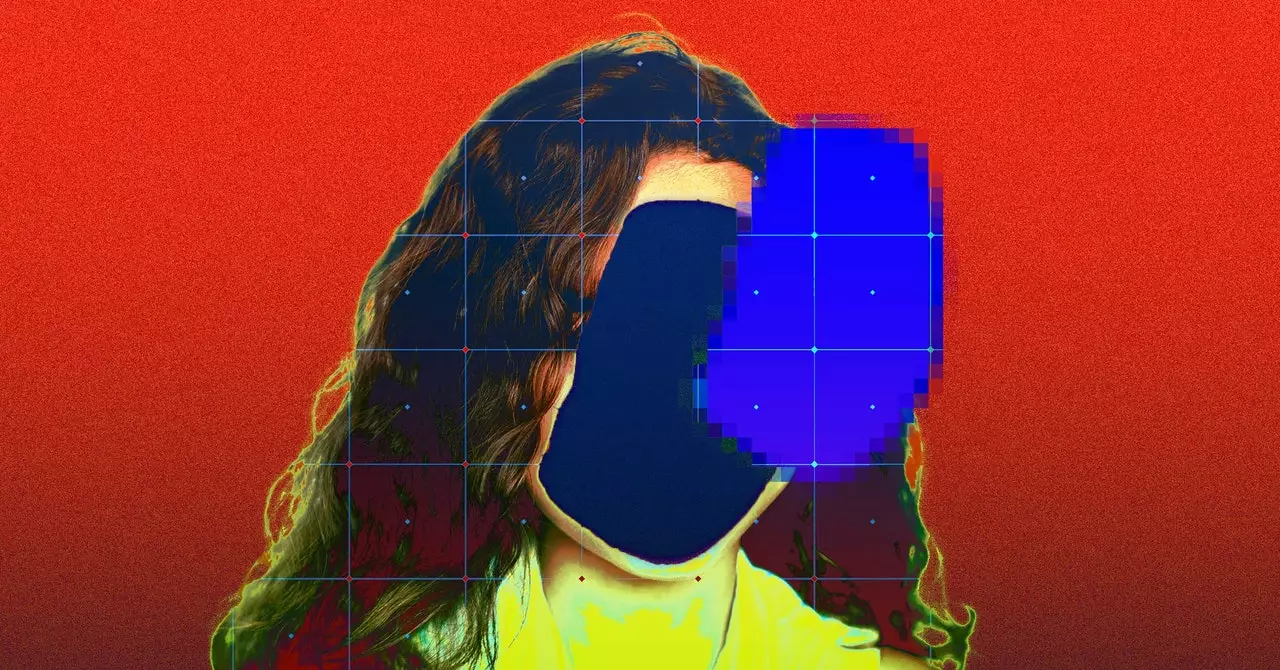

El uso de imágenes de niños sin su conocimiento o consentimiento para entrenar inteligencia artificial ha generado serias preocupaciones éticas. Human Rights Watch recientemente informó que más de 170 imágenes de niños de Brasil han sido recopiladas e incluidas en el dataset LAION-5B, violando su privacidad en el proceso. Estas imágenes, obtenidas de blogs de mamás, blogs de crianza y videos de YouTube, fueron recopiladas sin el consentimiento de los niños y utilizadas para entrenar modelos de IA, poniéndolos potencialmente en riesgo de explotación.

Respuesta y acciones tomadas

Los detalles personales de estos niños, junto con enlaces a sus fotografías, fueron incluidos en el dataset LAION-5B, el cual es accesible públicamente para investigadores. A raíz del descubrimiento de enlaces a contenido ilegal en el dataset LAION-5B, la organización detrás de éste, LAION, ha tomado medidas para eliminar las imágenes ofensivas. Colaborando con organizaciones como la Internet Watch Foundation, el Canadian Centre for Child Protection, Stanford y Human Rights Watch, LAION está trabajando para abordar el problema y garantizar que se eliminen todas las referencias a contenido ilegal.

Repercusiones y llamado a la acción

El uso no autorizado de imágenes de niños en datos de entrenamiento de IA sigue siendo una preocupación significativa. YouTube, cuyo contenido fue recopilado para obtener imágenes incluidas en el dataset LAION-5B, ha declarado que dicho raspado no autorizado viola sus Términos de Servicio. La plataforma continúa tomando medidas contra este tipo de abusos, resaltando la importancia de respetar la privacidad de los usuarios y garantizar que su contenido no se utilice sin su consentimiento. La inclusión de imágenes de niños en datos de entrenamiento de IA sin permiso es una violación de sus derechos y debe ser abordada.

La utilización de imágenes de niños para entrenar modelos de IA plantea preocupaciones sobre su seguridad y bienestar. Más allá del riesgo de generar material de abuso sexual infantil (CSAM) utilizando estas imágenes, existe la posibilidad de que se exponga información sensible, como ubicaciones o datos médicos. Los casos de deepfakes utilizados para acosar a compañeras de clase, especialmente niñas, en escuelas de los EE. UU., subrayan la importancia de proteger la privacidad de los niños y garantizar un uso responsable de sus datos. La inclusión no autorizada de imágenes de niños en datos de entrenamiento de IA es una seria violación de su privacidad y derechos.

La colaboración entre empresas tecnológicas, investigadores y organizaciones de derechos humanos es crucial para abordar estas preocupaciones éticas y proteger a los niños de posibles explotaciones. Es imperativo que las prácticas de recopilación de datos prioricen el consentimiento, la transparencia y el uso ético para proteger a los miembros más vulnerables de la sociedad.

Deja una respuesta